Les défis de l'IA (2/2)

Creusons les projets où l'IA peut être véritablement utile pour construire un futur plus cool. Le sujet chaud du moment !

Hello les plongeurs, voilà la newsletter du Plongeoir #73.

La semaine dernière on a plongé dans les enjeux de l’IA. Si tu ne l’as pas encore lu, c’est par ici que ça se passe.

C’est le sujet chaud du moment. Aujourd’hui, je te propose de voir quels sont les défis à relever dès aujourd’hui.

Et avant de plonger à pieds joints dans l’IA, parlons de cochons 🐖. Rien de plus sérieux !

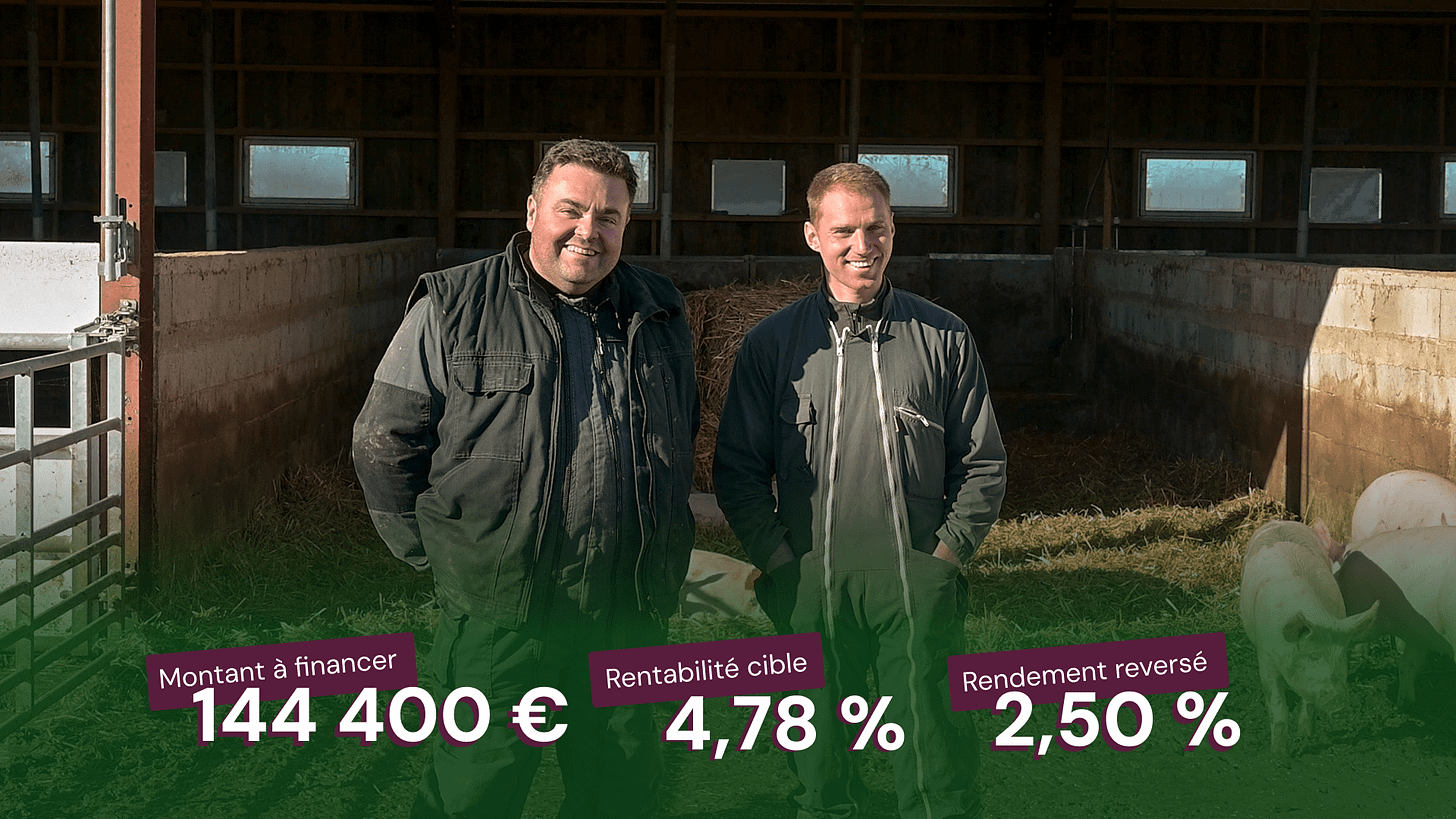

Le partenaire du jour : Hectarea.

Philippe et Cédric cultivent à Vaureilles dans l'Aveyron.

Ils font partie du 1% des élevages de cochons qui sont bio en France. Des pionniers, depuis 1992.

Avec Hectarea, tu peux les aider à investir dans des terres pour qu’ils atteignent l’autonomie alimentaire de leur ferme. Ils veulent produire blé, orge, pois, féverole, avoine et seigle.

Pourquoi c’est intéressant :

Élevage bio, circuits courts, vente dans les cantines locales et sur les marchés. Ils produisent même leur jus de pommes et des pâtes !

Rentabilité cible : 4,78%.

Le dernier projet d’Hectarea a été financé en moins d’une semaine. Ne tarde pas, celui-là en est déjà à 66%.

Tu peux participer à partir de 500€ :

Ps : ceci n’est pas du conseil en investissement, juste un sponsor que je trouve utile :)

Si ce n’est pas déjà fait tu peux aussi :

Devenir sponsor : Il suffit de répondre à cet email.

Rejoindre la communauté Plouf pour rencontrer ton associé.e. Nouveau site web tout en couleurs ;)

Te préinscrire à notre nouvel évènement Parés à virer, les 24 et 25 septembre à La Trinité sur mer. Déjà 400 demandes 🙃…

Lire les précédentes newsletters du Plongeoir.

Allez go !

Si tu as 30 secondes

Défis 🤝 : Il faut entreprendre en étant techno-lucides. Il faut se demander où l’IA est vraiment nécessaire et ne crée pas d’effets rebonds. De beaux projets peuvent naître dans le verdissement de l’industrie, la modélisation climatique, ou la sobriété des data centers par exemple.

Dates 🕰️ : L’IA nous entoure depuis 70 ans. L’IA générative a mis le sujet au coeur du quotidien du grand public récemment, mais c’est fascinant de remonter dans l’histoire pour comprendre comment tout est né.

Action 🖐️ : Tu as envie d’agir pour une IA plus responsable ? Il y a beaucoup à faire, notamment dans les entreprises. Si tu es dev ou data scientist, tu peux aussi être bénévole pour Dataforgood.

Ressources 📚 : Livres, podcasts, newsletters, tu as de quoi creuser !

J’ai co-écrit cette newsletter avec Alice Carré-Seemuller. Merci !

On plonge ?

Si tu as 5 minutes

Oups, cet e-mail sera coupé avant la fin. Lis-le directement dans ton navigateur 👇

1. Défis 🤝 : Entreprendre en étant techno-lucides.

Heureusement, l’IA ne sert pas qu’à créer des vidéos virales d’animaux mignons ou intensifier l’extraction de pétrole.

L’impact environnemental net de l’IA est largement négatif, et son impact social et politique loin d’être neutre.

Il faut devenir sobres et apprendre à utiliser l’IA uniquement là où c’est fondamental et pas en systématique.

C’est notamment l’avis de Lou Welgryn, secrétaire générale de Dataforgood. Elle nous a envoyé un petit vocal canon pour nous détailler ça. Merci Lou !

Je pense malgré tout que certaines utilisations de l’IA restent utiles aujourd’hui. Creusons !

Utiliser l’IA là où c’est vraiment utile

En médecine par exemple, de nombreux projets sont pertinents. De grandes avancées peuvent être réalisées sur le dépistage de cancers, ou la détection d’anomalies échographiques.

Le problème, c’est qu’il y a souvent des effets rebonds. Un bon exemple est la taille des modèles d’IA. Il paraît évident de développer des modèles d’IA beaucoup moins gourmands en énergie. Mais l’effet rebond est que plus ils deviennent miniatures, plus on peut les intégrer dans tous les objets mobiles du quotidien, des téléphones aux montres.

Le projet IT4Green de l’Ademe est super intéressant : il veut identifier les solutions IA qui ont un impact environnemental net positif, en intégrant au maximum les effets rebond potentiels (Il n’est bizarrement plus dispo depuis le 6/03, voyons si ça change, on se croirait chez Trump. En attendant voici un doc et un référentiel pour l’IA frugale).

Alors où peut-il y avoir des bénéfices nets ?

C’est le cas dans le verdissement de l’industrie par exemple :

L’IA peut optimiser la gestion des ressources et des stocks des usines, ou minimiser le gaspillage.

Energiency permet par exemple de réduire la consommation d’énergie des sites industriels.

La modélisation climatique est aussi super intéressante à l’ère de l’IA :

L’information climatique permise par l’IA peut aider à dépasser la très grande complexité de la science du climat. Il faut traiter des volumes colossaux de données, anticiper des catastrophes naturelles, etc. Ça peut aider autant sur l’atténuation que l’adaptation au changement climatique.

Il faut être très prudent sur les chiffres par contre. Beaucoup de géants de la tech utilisent l’information climatique comme raison pour excuser tous les usages excessifs de l’IA. Les études sont donc souvent financées par ces géants.

Les rapports climatiques et articles scientifiques eux-mêmes sont très complexes et denses. Les rapports du GIEC sont un bon exemple. L’IA peut permettre de les vulgariser, comme le montre le super projet ClimateQ&A.

L’IA aide aussi au suivi de la pollution plastique. The Plastic Tide repère par exemple les déchets plastiques par drones et grâce à l’IA.

Réduire l’impact des data centers

Si on ne peut pas se passer totalement de data centers, on peut essayer de réduire leur empreinte.

En France, la loi Zéro Artificialisation Nette (ZAN) pousse à maximiser la densité surfacique des data centers. C’est un mot compliqué pour dire qu’il faut qu’ils soient plus efficaces et qu’ils s’étalent le moins possible. Objectif : réduire l’artificialisation des terres.

La loi incite aussi à viser la transformation de bâtiments existants. On peut réhabiliter des friches plutôt que de bétonner plus d’espaces naturels.

Il y a 11 000 sites en friche en France, et beaucoup de bâtiments sont vides et adaptés à des data centers. C’est le cas de surfaces commerciales désaffectées, d’anciens centres téléphoniques (notamment dans le patrimoine d’Orange), de bureaux inoccupés, d’anciens sites industriels...

Certains data centers ont même trouvé place dans des lieux insolites :

Une citadelle anciennement poudrière classée au patrimoine de l’UNESCO à Arras.

Une ancienne carrière troglodyte enfouie sous une vigne à Saumur.

Un bunker anciennement base de sous-marins allemande à Marseille.

Un abri atomique et sous-sol d’une piscine publique à Paris.

Sous l’eau, des data centers sous-marins permettent aussi de réduire la consommation d’énergie et d’eau liée au refroidissement des serveurs.

Et même dans l’espace comme Spaceborne Computer-2 sur la station spatiale ISS

Parfois les reconversions d’espaces inutilisés en data centers peuvent aussi servir à économiser d’autres ressources :

Le consortium Deep Data dans le Saumurois utilise la chaleur souterraine ambiante pour refroidir les serveurs.

Le data center marseillais Interxion bénéficie d’un système de “river cooling”. Cette boîte récupère l’eau fraîche d’une ancienne galerie minière pour refroidir de façon naturelle les data centers par échange thermique.

Stimergy chauffe la piscine de la Butte aux Cailles (Paris) par un système d’échangeurs thermiques qui récupèrent la chaleur dégagée par les serveurs pour réchauffer l’eau des bassins.

La chaleur fatale des data centers est un gisement de chaleur à valoriser pour réduire l’impact environnemental des data centers. On ne peut pas toujours l’utiliser, mais bon aujourd’hui on ne la valorise qu’à hauteur de 3% !

Évidemment il ne faut pas que cela devienne une excuse pour en installer 10 fois plus (coucou les effets rebonds), mais utiliser leur chaleur reste important.

Le data center d’Infomaniak fournira au réseau de chaleur du canton de Genève une capacité de 1,7 MW, soit l’équivalent de l’énergie nécessaire pour chauffer 6 000 foyers.

Les grands opérateurs ont aussi lancé des projets de récupération, comme Facebook au Danemark. Ils valorisent la chaleur de leur méga data center pour alimenter le réseau de la ville et couvrir les besoins de 6 900 foyers. Microsoft en Finlande a noué un partenariat avec l'énergéticien Fortum pour construire le plus grand data center au monde et valoriser sa chaleur fatale. Ils vont couvrir 40% des besoins de chauffage du district d'Helsinki.

On peut aussi utiliser la chaleur autrement. C’est ce que veulent faire Data4group et l'Université Paris Saclay avec leur projet pilote de “data center bio circulaire”. La chaleur sera utilisée pour faire pousser des algues et les recycler en biomasse.

Faire preuve de discernement sur l’IA, c’est l’utiliser uniquement quand c’est vraiment utile. C’est aussi optimiser les ressources pour que les data centers deviennent plus sobres et circulaires.

Etre efficace et frugal dans les usages

On n’a pas toujours besoin de sortir l’artillerie lourde. Un vrai défi va être de créer une bonne adéquation entre le besoin recherché en IA et l’outil utilisé.

On voit de plus en plus d’usages aberrants. On va gagner 5 secondes pour écrire un email en utilisant 3 modèles d’IA qui se succèdent par exemple.

On n’a peut-être pas besoin d’utiliser une IA basée sur des milliards de données pour connaître la météo locale. Parfois une recherche web basique donne la bonne réponse. On peut même juste regarder les nuages ;)

Qu’est-ce qui pourrait être développé pour aider les utilisateurs à utiliser le moyen le moins énergivore pour chaque question posée ?

Si tous ces défis te donnent des idées, n’hésite pas à rejoindre notre communauté Plouf.

Voilà les principaux sujets qui sont discutés en ce moment sur l’IA :

L’IA pour optimiser les supply chain.

L’IA pour favoriser la logistique des circuits courts.

L’IA et l’optimisation des énergies renouvelables.

L’IA pour l’éducation, et la formation.

L’IA et les CivicTech pour réduire les biais des modèles, et la désinformation.

Si tu as 10 minutes de plus

Si tu as 10 minutes de plus, je te propose :

2. Dates : L’IA nous entoure depuis 70 ans.

3. Action : Utiliser le collectif pour agir.

4. Ressources : Livres, podcasts, newsletters pour creuser.

Oups, cet e-mail sera coupé avant la fin. Lis-le directement dans ton navigateur 👇

2. Dates 🕰️ : L’IA nous entoure depuis 70 ans.

L’IA est tout sauf jeune. Les récentes IA génératives ne sont qu’une nouvelle version grand public qui a boosté la visibilité et l’engouement pour l’IA.

1943 : Prémices de l’intelligence artificielle, les scientifiques Warren McCullough et Walter Pitts présentent le premier modèle mathématique pour la création d’un réseau de neurones.

1946 : le Laboratoire de balistique de l’Armée américaine construit le premier ordinateur universel de l’histoire, l’ENIAC, considéré comme l’ancêtre des data centers. À l’origine, un seul gigantesque ordinateur remplit des bureaux entiers. Il occupe 167 m² d’espace physique et consomme plus de 1500 kW. D’ailleurs, il faut rendre hommage aux 6 femmes qui ont été clefs dans ce projet.

1950 : le 1er ordinateur à réseau de neurones apparaît et Alan Turing crée le Turing Test, dont découlent les fondations de l’intelligence artificielle : répliquer ou simuler l’intelligence humaine dans les machines.

1956 : première apparition du terme d’intelligence artificielle, prononcée par John McCarthy, principal pionnier du domaine.

1989 : Premier data center en colocation à New York. Avec l’augmentation de la vitesse des réseaux et face aux problèmes de bruit, de réfrigération, de sécurité et de coût de maintenance, des lieux de stockage des données spécifiques deviennent nécessaires pour héberger les serveurs.

1997 : Kasparov, le meilleur joueur d’échec au monde est battu par Deep Blue d’IBM.

2006 : Premier centre de données hyperscale (massif) lancé par Google à The Dalles, dans l’Oregon. Ils sont désormais 1 000 dans le monde. Pour être qualifiés d’hyperscale, ces “titans de la tech” doivent dépasser 930m2 et héberger plus de 5 000 serveurs. Celui de The Dalles fait désormais 120 774 m2 et a consommé en 2022 1,039Mds de litres d’eau … Mais il est très loin de figurer dans le top 5 des plus gros data centers du monde : l’Inner Mongolian Information Hub occupe plus de 9,3 millions de m2… 55 688 fois la surface de l’ancêtre ENIAC de 1946 !

2012 : AlexNet - prédit avec une exactitude de 85% si un chat se trouve sur la photo. Les réseaux de neurones commencent à être reconnus au sein du cercle des chercheurs et des initiés.

2016 : AlphaGo (DeepMind, racheté par Google) bat Lee Sedol au jeu de Go - un jeu chinois infiniment plus complexe que les échecs. Onde de choc sur les capacités des IAs qui commence à les faire sortir d’un cercle d’initiés.

2017 : sortie du papier ‘Attention is all you Need’ de Google sur les IA génératives.

2022 : sortie de chatGPT par OpenAI (dirigé par Sam Altman) et ouverture au grand public de l’IA générative.

2023 : le développement effréné de l’IA et des data centers par les géants de la tech les fait dérailler par rapport à leurs objectifs climatiques.

2024 : Open AI quitte son statut d’ONG à but non lucratif et devient une entreprise. De nombreux cadres démissionnent car ils ne sont plus alignés avec les valeurs et la recherche de l’entreprise.

Sept 2024 : La lanceuse d’alerte Holy Alpine dénonce le double discours climatique de Microsoft.

Janvier 2025 : Meta introduit des comptes générés par l’IA et annonce la fin du fact-checking sur ses réseaux sociaux aux Etats-Unis. L’Europe résiste, mais jusqu’à quand ? Le jour de l’investiture de Donald Trump, à l’initiative du mouvement HelloQuitteX, des dizaines de milliers d’internautes français et de nombreux grands comptes quittent le réseau social X. Deux jours après, le nouveau Président américain annonce le lancement de Stargate, projet à 500 milliards de dollars destiné à bâtir les centres de données géants de la future génération d’IA.

Février 2025 : Sommet mondial de l’IA à Paris. Emmanuel Macron annonce 109 milliards d’euros d’investissement dans l’IA en France.

3. Action 🖐️ : utiliser le collectif pour agir

Agir dans les entreprises

Le risque est grand pour les entreprises de tomber dans le panneau du techno-optimisme naïf. On a souvent l’impression qu’en 2025 il faut absolument mettre de l’IA partout pour être efficace.

Ça me fait penser à l’époque où si tu n’avais pas des OKR (une méthodo pour gérer les projets) dans ta startup il était évident que tu ne pouvais pas être efficace.

L’IA est par exemple de plus en plus utilisée dans l’organisation des tâches et le management. Mais ça peut créer un manque de motivation totale. Chez Amazon, les employés suivent la cadence imposée par une IA dans les entrepôts par exemple. Qui a vraiment envie de travailler pour suivre ce qu’une IA a trouvé important de faire aujourd’hui ?

Le sujet de l’anxiété créée par l’IA dans les boîtes n’est pas nouveau. La peur d’être “remplacé” existait déjà quand on craignait les robots, elle s’amplifie encore avec l’IA. Il y a dans tous les cas un gros enjeu de communication et de dialogue social. Il peut être intéressant d’organiser la Fresque de l’IA pour en parler ?

Les entreprises ont peu de pouvoir pour influencer les équipements des data centers. Elles peuvent déjà réduire leur utilisation de data et d’IA ;) Et ensuite privilégier le “green hosting” pour héberger leurs données :

C’est loin d’être neutre en carbone et en eau, mais ça permet de minimiser l’impact du data center (énergie renouvelable, optimisation de la consommation énergétique et des systèmes de refroidissement, réduction et recyclage des déchets électroniques…).

C’est ce que proposent les québécois Ex2, le suisse Infomaniak ou la française Ikoula. Le site de la Green Web Foundation permet de vérifier si les sites internet et les hébergeurs web utilisent de l’énergie renouvelable. On peut rechercher sur leur annuaire les hébergeurs verts partout dans le monde.

Pour les boîtes de “data science”, il est aussi possible d’entrer dans une démarche d’amélioration :

Il existe la labellisation “IA responsable et de confiance”.

GenAI Impact est un outil pour les développeurs, créé dans le prolongement du livre blanc de Data for Good. Ils développent des outils opérationnels open source pour évaluer et réduire l'impact environnemental de l’IA générative.

Agir si on est dans la Tech

Data for Good anime une communauté de plus de 6 000 experts de la tech bénévoles qui donnent de leur temps pour aider des projets d’intérêt général basés sur la donnée. Ils ne mobilisent l’IA qu’en cas de besoin et de façon proportionnée aux enjeux.

Les bénévoles de l’asso s’engagent à respecter les 25 principes du “Serment d’Hippocrate du Data scientist”.

C’est intéressant de comprendre ce qu’il y a dedans :

Utiliser les datas pour faire émerger des sujets dans le débat public. Le projet CarbonBombs a été co-créé avec l’asso Eclaircies par exemple. Data For Good a créé une carte mondiale répertoriant les 425 plus grands projets d'extraction de ressources fossiles, surnommés "bombes carbone". Ce projet a fait l’effet d’une bombe médiatique.

Aider les citoyens à faire des choix de consommation plus éclairés. Par exemple le projet PinkBombs a été co-créé avec l’association Seastemik. Il raconte l’histoire de la pêche industrielle du saumon, provenant à 99% de cages marines. Ils ont compilé des données et construit une plateforme pour quantifier l’impact. Là encore, une bombe médiatique révélant que le saumon n’est pas toujours rose.

Construire des outils internes qui permettent aux associations de décupler leur impact par la donnée. L’outil "Trawl Watch" a été construit avec Bloom. Data For Good a développé une plateforme de suivi en temps réel de plus de 2000 bateaux de pêche, fournissant des données critiques pour les actions en justice et les actions terrain contre les pratiques de pêche dans les aires marines protégées.

Agir au niveau légal

La réglementation du développement de l’IA est fondamentale pour contrer ses effets les plus dangereux. De premières briques ont commencé à être mises en place en Europe avec le règlement sur les services numériques (Digital Service Act) et la loi sur l'intelligence artificielle de l'UE (IA act).

Les “innovateurs” accusent cette régulation d’aller trop loin en freinant l’innovation, tandis que les “régulateurs” l’accusent d’être totalement insuffisante face à la déferlante en cours.

L’IA Act a par exemple régulé en 2024 l’usage de l’IA pour accorder des crédits bancaires. En gros la banque devra démontrer avant de mettre en production une IA qu’elle n’est pas discriminatoire au niveau racial, handicap, âge, orientation sexuelle etc.

L’idée dans la régulation des secteurs les plus sensibles est d’inverser la charge de la preuve. C’est déjà le cas pour les médicaments : c’est aux fabricants de montrer qu’un médicament n’est pas nuisible (tests poussés sur la conformité, les usages possibles, les impacts environnementaux…) avant de pouvoir l’utiliser.

Réguler, c’est aussi surveiller et encadrer. C’est l’objectif de la création de l'Institut national de l'évaluation et de la sécurité de l'IA (Inesia) annoncée en janvier en France, dans le but de développer une IA responsable, éthique et sécurisée.

4. Ressources clefs 📚

De nombreux supports existent pour s’informer et prendre le temps de comprendre ce qu’est l’IA générative et les implications qu’elle a sur la société.

C’est par exemple l’objectif du livre blanc de Data for Good “les grands défis de l’IA générative”, qui a donné lieu à d’autres ressources (webinaire, newsletter, développements comme GenAI Impact…).

Déjà le Shift Project vient de sortir son rapport intermédiaire sur l’IA, à lire !

Pour comprendre le fonctionnement d’une IA :

Vertiges de l’IA : newsletter du Plongeoir (26/01/2024) qui vulgarise le fonctionnement d’une IA.

The Tunnel : newsletter de Quentin Bragard, entrepreneur qui défriche le fonctionnement des modèles d’IA.

Quelques livres :

Contre Atlas de l’Intelligence Artificielle - Kate Crawford : un livre génial qui fait un état des lieux de l’impact de l’IA et de l’importance de sortir d’une vision fausse qui la penserait uniquement comme purement technique.

Eloge du Bug - Marcello Vitali-Rosati - excellent livre pour interroger notre rapport aux outils, leur efficacité et la modélisation du monde induite par les plateformes numeriques.

Algocratie : Vivre libre à l’heure des algorithmes - Arthur Grimonpont - un livre extrêmement didactique, avec de nombreux exemples concrets, pour comprendre comment les réseaux sociaux façonnent notre accès à l’information.

Les prophètes de l’IA de Thibault Prévost : pour comprendre les ressorts économiques et idéologiques qui animent les géants de la tech.

Géopolitique du numérique de Ophélie Coelho - un excellent livre pour comprendre l’histoire du développement du numérique, et l’imbrication entre gouvernements, entreprises et big tech.

Patriatech de Marion Olharan Lagan - qui parle de l’invisibilisation des femmes dans la tech et retrace l’histoire d’internet en mettant la lumière sur les femmes qui ont fait l’histoire.

Podcasts & newsletterss

Your undivided attention : un podcast (américain) qui pose de nombreuses questions sur le développement de l’IA.

Le code a changé - tout simplement génial pour se poser plein de questions sur la technique.

404 media : un média d’investigation sur l’impact de la tech et de l’IA dans nos vies.

Associations et personnes à suivre

Gen AI Impact : une association née au sein de Data for Good qui construit des outils pour estimer l’empreinte carbone des LLM (Large Language models)

AI forensics : ils mènent une recherche fondamentale pour percer l’opacité des algorithmes et leur impact sur la démocratie.

Tournesol : co-fondé par Lê Nguyên Hoang, qui développe un algorithme de recommandation d’utilité publique, pour des contenus utiles plutôt qu’addictifs.

Sasha Lucioni : Responsable de recherche IA et Climat chez Hugging Face - dont un résumé de ses recherches sur l’impact environnemental de l’IA.

Irénée Régnault : chercheur indépendant, co-fondateur du mouton numérique et auteur de “technologie partout, démocratie nulle part”.

Et évidemment Lou Welgryn et l’asso Dataforgood.

Voilà, c’est terminé pour aujourd’hui. Merci de nous avoir lus jusqu’au bout.

🙏 Énorme merci à Alice pour la coécriture.

Merci aussi à Pierre et sa super newsletter, il m’aide à communiquer ce contenu au plus grand nombre, notamment par Linkedin.

J’ai deux derniers services à te demander :

Mets un petit like / commentaire avec ton ressenti :)

Si tu as trouvé cette newsletter utile, partage-la. C’est uniquement comme ça que ce projet grandit.

Et si ça t'a donné envie de te lancer, rejoins la communauté Plouf, pour te connecter, challenger et rencontrer ta/ton associé.e !

À très vite,

Merci pour l'article ! Je rajoute un livre Hyperarme https://hyperarme.com/ :)

Votre article met en lumière des solutions concrètes et ingénieuses pour réduire l'empreinte écologique des dates centers au fils des années. Merci pour cette lecture enrichissante.